Quando sono arrivate le AI generative, è esplosa la moda dei corsi e delle guide con i “100 prompt da copiare e incollare”. Sembrava la soluzione perfetta per chi cercava scorciatoie: facile, veloce, quasi magico. Ma il problema è che, come al solito, queste scorciatoie sono la strada migliore per fare peggio. Ora stiamo assistendo a un nuovo trend: creare assistenti AI personalizzati, o GPT su misura, rigorosamente in velocità.

Ora, la progettazione e realizzazione di un assistente AI personalizzato è sicuramente un’ottima idea. È una parte fondamentale del percorso di personalizzazione delle AI, un modo per adattare la tecnologia alle proprie esigenze. Ma, ancora una volta, c’è il rischio di illudersi che basti un clic per ottenere un risultato efficace.

La realtà è che, oltre al tempo per scrivere un caso d’uso, capire quale AI scegliere, progettare l’assistente, scrivere le regole, creare la knowledge base e fare una delle forme di fine tuning consentite, poi serve tempo per testarlo.

E se si saltano i passaggi fondamentali, quello che sembrava un risparmio iniziale si trasforma in tanto, tanto, tanto tempo perso.

In questo articolo vediamo come si fa l’alpha testing. Cioè: siamo in questa situazione. Abbiamo deciso cosa fare con un AI assistant personalizzato, lo abbiamo realizzato e finalmente siamo pronti per lavorarci. Ma prima, appunto, bisogna fare dei test.

Come si testa un AI Assistant personalizzato: alpha test

Indice dei contenuti

L’alpha test è la fase iniziale del test, durante la quale si raccolgono feedback da un gruppo ristretto di persone per identificare eventuali problemi e migliorare il sistema. Ecco i passi principali.

1. Reclutare alpha tester

Il primo passo è coinvolgere persone di vario genere e varie competenze per testare l’assistente AI. Gli alpha tester possono essere:

- persone esperte: con competenze specifiche nel settore d’uso dell’assistente. Offrono feedback tecnico e possono individuare limiti nel design.

- persone non esperte: rappresentano il pubblico generico e aiutano a testare l’accessibilità e l’intuitività del sistema. Vanno bene anche quelle che non hanno mai usato un’AI assistant

Un mix di profili garantisce una visione completa dei punti di forza e delle debolezze.

2. Progettare un form di feedback

Un form ben progettato è essenziale per raccogliere dati strutturati. Deve includere:

- domande chiuse: ad esempio, scale da 1 a 5 per misurare aspetti come chiarezza delle risposte e facilità d’uso;

- domande aperte: per raccogliere suggerimenti e dettagli su eventuali problemi;

- domande tecniche: per verificare la correttezza degli output e delle funzionalità principali;

- la possibilità di uploadare il contenuto della chat

Esempi di domande:

Questo approccio consente di raccogliere dati quantitativi (medie, percentuali) e qualitativi (feedback dettagliati), oltre a permettere un’analisi diretta di come le persone hanno usato il chatbot

3. Osservare l’uso reale del sistema

Lascia che i tester usino l’assistente in modo libero e spontaneo, simulando scenari d’uso reali. Questo ti permette di capire se il sistema è intuitivo e funzionale. Puoi anche proporre task specifici, come:

- generare un report

- rispondere a una domanda complessa

- creare un documento formale

Se possibile, osserva qualcuno mentre usa l’assistente. Se no, fatti mandare l’intero log dell’interazione con lo strumento.

4. Analizzare il feedback

Dopo la raccolta, il feedback deve essere analizzato per individuare pattern ricorrenti e problemi. Puoi:

- calcolare medie e tendenze dai dati quantitativi

- analizzare i commenti aperti per temi ricorrenti e criticità specifiche.

Strumenti come ChatGPT, Claude o altre AI possono aiutarti a riassumere le risposte aperte, individuare errori sistematici e suggerire miglioramenti, analizzare le chat e, in generale, darti una mano nel capire cosa non ha funzionato. È importante concentrarsi in particolare sui feedback negativi e sulle richieste di miglioramento o sulle osservazioni.

Per esempio, chiedi a ChatGPT di

- fare l’analisi delle risposte quantitative

- analizzare log di chat individuando errori ricorrenti o risposte incoerenti.

- organizzare i dati: aiutandoti a strutturare e visualizzare le informazioni raccolte

- individuare i problemi più frequenti nelle risposte aperte

Questo approccio ti permette di risparmiare tempo e concentrarti sull’implementazione dei miglioramenti.

5. Iterare e migliorare

Usa i risultati dell’analisi per ottimizzare il tuo assistente AI. Ad esempio:

- migliora le regole per correggere risposte errate

- migliora le regole per modificare il modo in cui il GPT risponde

- migliora la knowledge base

Ogni miglioramento deve essere testato con un nuovo ciclo di alpha testing.

Se hai progettato bene l’assistente non serve molto tempo e bastano pochi feedback, per questa fase.

Il caso del FOIABot: un esempio pratico

Il FOIABot è un assistente AI progettato per aiutare giornaliste e giornalisti a generare richieste FOIA e accessi civici. Durante l’alpha test è stato utilizzato un form dettagliato per raccogliere feedback su aspetti chiave come:

- Chiarezza: il bot guidava l’utente in modo chiaro?

- Completezza delle risposte: raccoglieva tutte le informazioni necessarie?

- Conformità dell’output: i moduli generati erano completi e corretti?

- Suggerimenti: quali miglioramenti proponevano i tester?

Puoi vedere il form completo qui.

Grazie al feedback, sono stati identificati problemi come la mancata inclusione di alcuni dati nei moduli e difficoltà nell’interpretazione di richieste particolarmente complesse. Ogni problema è stato affrontato con iterazioni successive, migliorando la precisione e l’utilità del FOIABot.

Questo è l’elenco completo delle domande del form, che si può riadattare a qualunque tipo di assistente AI.

- Avevi mai fatto richieste FOIA o accessi civici prima d’ora? Sì/No

- Quanto è stato chiaro il GPT nel guidarti durante la richiesta? (Scala da 1 a 5)

- Il GPT ha raccolto correttamente tutte le informazioni necessarie per aiutarti? Sì/No

- Il GPT ha risposto correttamente alle tue richieste? Sì/No

- Il GPT ti ha guidato e ti è stato di aiuto? Sì/No

- Per favore, incolla qui il link della tua chat col GPT

- Se hai avuto delle difficoltà d’uso puoi descriverle? Per esempio: cosa ti aspettavi che facesse il GPT? C’è qualcosa che non hai capito? C’è qualcosa che il GPT non ha capito? Cosa avrebbe dovuto saper fare? Cosa ha fatto male? Insomma: scrivi tutto ciò che ci aiuta a capire il problema. Risposta aperta

- Ti ha dato informazioni errate? Sì/No

- Se sì, quali informazioni erano errate? Spiega nel dettaglio per favore Risposta aperta

- Puoi descrivere la tua esperienza d’uso? Com’è andata? Cosa ti è piaciuto? Cosa ti ha dato fastidio? Più dettagli aggiungi meglio è per sistemare i problemi Risposta aperta

- Hai usato il GPT per generare un modulo compilato? Sì/No

- Puoi caricare qui il pdf del modulo? (Pdf, max 10 MB)

- Il modulo generato era completo e conforme al modello da usare? Sì/No

- Se mancavano delle parti al modulo, puoi dirci quali? Risposta aperta

- Quanto tempo hai impiegato per avere quel che ti serviva? (scelta fra: meno di 5 minuti – da 5 a 10 minuti – da 10 a 20 minuti – da 20 minuti a 30 minuti – più di 30 minuti e non ho avuto successo – più di 30 minuti ma è andato tutto bene

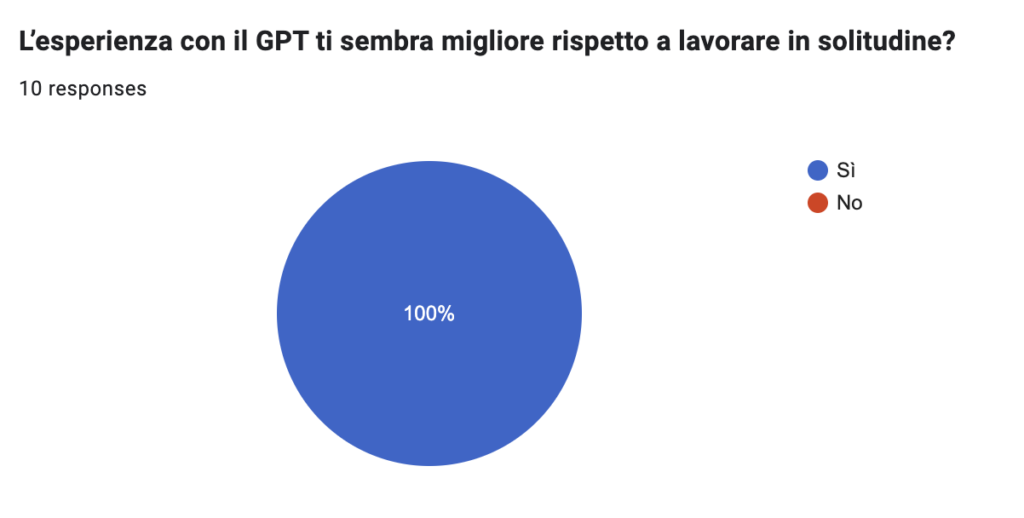

- L’esperienza con il GPT ti sembra migliore rispetto a lavorare in solitudine? Sì/No

- Che voto daresti complessivamente all’esperienza? Sì/No

- Cosa miglioreresti nel GPT? Risposta aperta

- Pensi che ci vogliano delle istruzioni per l’uso? (scegli tutto quel che servirebbe) Opzioni: Sì, scritte per punti chiave – Sì, direttamente dal bot – No, le ho chieste al bot – Sì, un video breve – Altro

- Quali sono le cose più urgenti da risolvere se hai avuto problemi? Risposta aperta

- Vuoi aggiungere altri commenti o suggerimenti? Risposta aperta

E poi il beta testing.

Dopo che l’alpha testing è terminato si può aprire il chatbot o l’assistente a un uso in “beta”. Consiglio di chiarire nella descrizione del chatbot che si trova ancora in una fase “beta”, di ribadire che può commettere errori e di proporre un altro form (magari più breve) per raccogliere eventuali altri commenti utili a migliorare.

Il valore del testing accurato

Testare un AI Assistant non è solo un passaggio obbligato: è la chiave per creare un sistema utile e affidabile. Un processo di testing accurato ti permette di individuare errori, raccogliere feedback significativi e migliorare progressivamente il funzionamento dell’assistente.

La personalizzazione delle AI è una grande opportunità, ma richiede tempo e attenzione. Investire nel testing significa non solo creare un sistema che funziona meglio, ma anche evitare problemi futuri che potrebbero costarti molto di più. Inizia bene, testa a fondo e migliora continuamente.

Lascia un commento